A Google anunciou hoje (8) quais serão as próximas novidades que chegarão para a Busca e para o Maps, dando novos passos para o uso de Inteligência Artificial (IA) para construir buscas mais contextuais com foco em imagens.

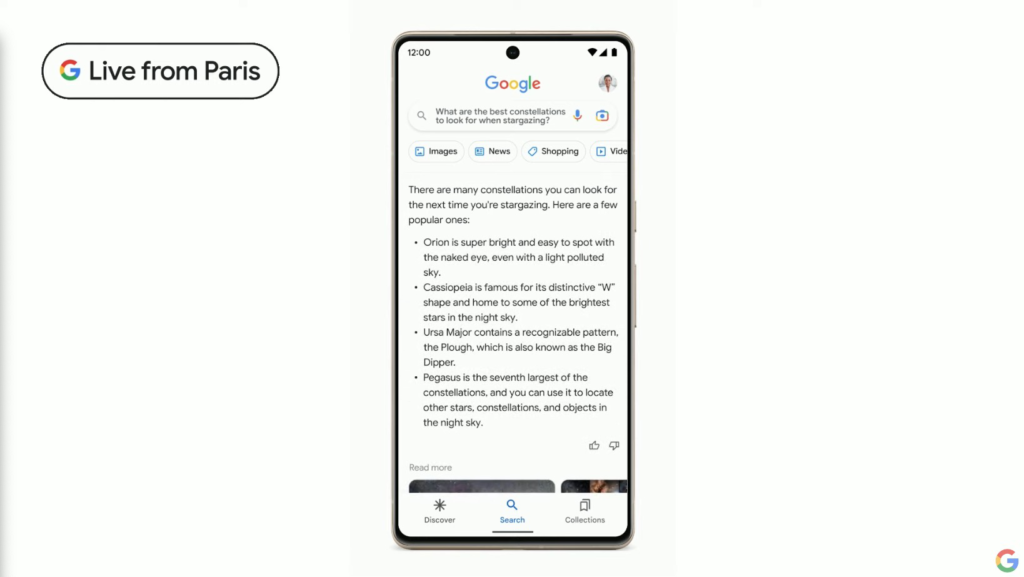

Por meio de uma demonstração, a companhia revelou como deverá utilizar a IA generativa para criar respostas mais contextuais e resumidas.

A Google explicou que, ao fazer uma pesquisa, o usuário receberá informações de múltiplas fontes com diferentes pontos de vista.

Isto é o que a empresa chama de NORA (No One Right Answer, ou “não há uma única resposta certa”, em tradução livre).

Juntamente, a Google também deve incluir links de matérias e perguntas de follow up para que o usuário possa se aprofundar no tema.

Ainda não há detalhes sobre quando a empresa deverá lançar esta função no buscador.

Novidade no Google Lens

A empresa trouxe novas ferramentas para o Google Lens, um recurso para pesquisas visuais usando o celular. Agora, há a “pesquisa direta pela tela” que deverá estrear, “nos próximos meses”, globalmente em dispositivos Android.

Com a ferramenta, o usuário pode iniciar o Google Lens pelo celular em uma página, pelo próprio celular, e então realizar uma busca pelo o que o dispositivo está mostrando. Como exemplo, ao receber um vídeo ou foto de um amigo por mensagem, o usuário pode buscar informações sobre o local exibido na imagem utilizando o Lens sem sair do aplicativo.

Multisearch disponível globalmente

Lançada em abril de 2022, a Multisearch, ferramenta que combina texto e imagem nas pesquisas, está agora disponível em todos os países e idiomas compatíveis com o Lens.

Com o Multisearch, os usuários podem capturar uma imagem usando o Lens e digitar algo específico, como a cor de um objeto. Uma novidade apresentada pelo Google, porém, é a possibilidade de fazer buscas “perto de mim” para encontrar algo em comércios locais.

Além disso, nos próximos meses a Google permitirá que os usuários do Lens façam buscas por qualquer imagem que encontrarem nos resultados de pesquisas no mundo todo utilizando o celular.

Entre em contato com a redação Money Crunch: [email protected]

Assine nossa newsletter

Assine nossa newsletter